| Казанский Государственный технический университет им. А.Н. Туполева

Кафедра Радиоуправления

Пояснительная записка к курсовой

работе по курсу

ТЕОРИЯ ЭЛЕКТРИЧЕСКОЙ СВЯЗИ

на тему

Пропускная способность канала.

Выполнил студент гр.5313

Алмазов А.И.

Руководитель: _____________

Оценка _____________

Комиссия ________ ( _______ )

________ ( _________ )

________ ( _________ )

Казань 2002

Оглавление.

1. Задание…………………………………………………………………..3стр.

2. Введение…………………………………………...……………………4стр.

3. Теоретическая часть…………...……………………………………….5стр.

4. Практическая часть………………………………..…………………..11стр.

5. Заключение………………………………………………..…………...14стр.

6. Литература…………………………………………….……………… 15стр.

Задание.

В канале действует аддетивный белый гаусовский шум. Отношение сигнал/шум (Pc

/Pш

) меняется с 25 до 15 дБ, с шагом 1дБ. F=1,5 кГц; Vк

=8*103

сим/с.

Рассчитать:

1) Изменение пропускной способности канала.

2) Изменение избыточности κ двоичного кода, необходимой для сведения ошибки декодирования к сколь угодно малой величине.

Построить графики зависимостей с=f(Pc

/Pш

) и κ= f(Pc

/Pш

).

Введение.

Поставленная задача интересна тем, что мы сможем проследить изменение пропускной способности канала с изменением отношения сигнал/шум . Можно определить пропускную способность С канала в расчете на один символ

Ссимвол

=maxI

(A,B),бит/символ

или в расчете на единицу времени (например, на секунду):

С=maxI

’(A,B)=u Ссимвол

, биит/с.

В данном случае мы будем рассчитывать относительно времени. Для этого мы воспользуемся формулой определяющей пропускную способность канала в расчете на единицу времени.

С=Fk

log2

(1+Pc/Pш),

А для того чтобы определить избыточность передаваемой информации воспользуемся теоремой Шеннона. При условии если теорема Шеннона будет выполняться, то избыточность κ будет равняться 0, значит информация передаётся без потерь. Если нет, то κ будет больше нуля (κ>0). Т.е. чем меньше величина κ, тем меньше будет вероятность ошибки декодирования.

Теоретическая часть.

Пропускная способность канала связи.

В любой системе связи через канал передаётся информация. Её скорость определяется по формуле:

I’(А,В)=H’(А)-H’(А|В)=H’(А)-H’(В|А). (1)

Величина H

(A

|B

) - это потери информации при передаче ее по каналу. Ее также называют ненадежностью

канала. H

(B

|A

) - энтропия шума

; показывает, сколько бит шумовой информации примешивается к сигналу. Передачу сигнала по каналу иллюстрирует рис. 1.

Рис. 1. Передача информации по каналу с помехами

Здесь I

’(A

,B

)=v

*I

(A

,B

) - скорость передачи информации по каналу.

Как видно из формулы (1), эта скорость зависит не только от самого канала, но и от свойств подаваемого на его вход сигнала и поэтому не может характеризовать канал как средство передачи информации.

Рассмотрим дискретный канал, через который передаются в единицу времени u символов из алфавита объёмом m. При передачи каждого символа в среднем по каналу проходит количество информации

I

(A,B)=H(A)-H(A|B)=H(B)-H(B|A), (2)

где А и В- случайные символы на входе и выходе канала. Из четырёх фигурирующих здесь энтропий Н(А)- собственная информация передаваемого символа определяется источником дискретного сигнала и не зависит от свойств канала. Остальные три энтропии в общем случае зависят как от источника сигнала, так и от канала.

Величина I

(A

,B

) характеризует не только свойства канала, но и свойства источника информации. Пусть на вход канала можно подавать сигналы от различных источников информации с различными распределениями P

(A

). Для каждого источника I

(A

,B

) примет свое значение. Максимальное количество информации

, взятое по всевозможным Р

(А

), характеризует только канал и называется пропускной способностью

(ПС) канала в расчете на один символ:

бит/символ,

где максимизация производится по всем многомерным распределениям вероятностей Р(А).

Также определяют пропускную способность С канала в расчете на единицу времени:

бит/с, (3)

где v - количество символов, переданное в секунду.

В качестве примера вычислим пропускную способность дискретного симметричного канала без памяти (рис. 2) с вероятностью ошибочного перехода - p

.

Рис. 2. Модель двоичного симметричного канала без памяти

Согласно свойству взаимной информации 2 можно записать: С

сим

=max(H

(B

)-H

(B

|A

)). Распишем H

(B

|A

). Исходя из условий задачи вероятность правильной передачи символа по каналу - 1-p, а вероятность ошибочной передачи одного символа p

/(1-m

), где m

- число различных символов, передающихся по каналу. Общее количество верных передач - m

; общее количество ошибочных переходов - m

*(m

-1). Отсюда следует, что:

.

Следовательно, Н(В/А) не зависит от распределения вероятности в ансамбле А, а определяется только переходными вероятностями канала. Это свойство сохраняется для всех моделей канала с аддитивным шумом.

Максимальное значение Н

(В

)=log m

. Отсюда следует:

. (4)

Пропускная способность в двоичных единицах в расчете на единицу времени:

. (5)

Для двоичного симметричного канала (m=2) пропускная способность в двоичных единицах в единицу времени

С=u[1+p*log(p)+(1-p)*log(1-p)] (6)

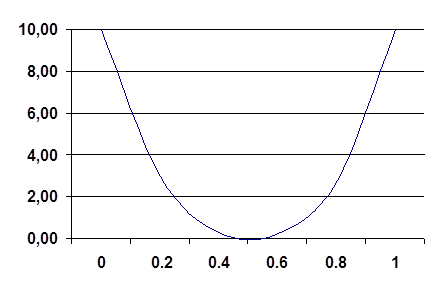

Зависимость С/u от р согласно (6) показана на рис.3

рис.3 Зависимость пропускной способности двоичного симметричного канала без памяти от вероятности ошибочного приёма символа.

При р=1/2 пропускная способность канала С=0, поскольку при такой вероятности ошибки последовательность выходных символов можно получить совсем не передавая сигнала по каналу, а выбирая их наугад, т.е. при р=1/2 последовательности на выходе и входе канала независимы. Случай С=0 называют обрывом канала

.

Пропускная способность непрерывного канала связи.

Вычисляется аналогично пропускной способности дискретного канала. Непрерывный сигнал дискретизируется во времени с помощью отсчетов согласно теореме Котельникова и информация, проходящая по каналу за время Т

, равна сумме количества информации, переданной за один отсчет. Поэтому общая ПС канала равна сумме ПС на один такой отсчет:

, (7)

где U

- переданный сигнал; Z

- сигнал на выходе канала с наложенными на него шумами; N

- шум; Z

=U

+N

.

Пусть U

и N

- случайные величины с плотностью распределения вероятности w

, распределенной по нормальному (гауссовскому) закону. Для таких сигнала и шума (см. вывод в [1, с. 114, 117-118]:

.

Отсюда следует:

.

ПС в расчете на секунду будет равна:

, (8)

поскольку при дискретизации сигнала по теореме Котельникова за одну секунду мы получим 2F

отсчетов, где F

- верхняя частота спектра сигнала.

Подчеркнем, что формула (8) имеет такой вид только при условии, что плотности распределения вероятностей w

(U

) и w

(N

) подчиняются нормальному закону.

Формула (8) имеет важное значение, т.к. указывает на зависимость ПС канала от его технических характеристик - ширины полосы пропускания и отношения мощности сигнала к мощности шума.

Чтобы выяснить как зависит пропускная способность от ширины полосы пропускания выразим мощность шума в канале через его одностороннюю спектральную мощность N

0

.

Имеем Рш

=N0

F; поэтому

С=F*log(1+ Pc/N0

*F )=F*loge*ln(1+Pc/N0

*F) (9)

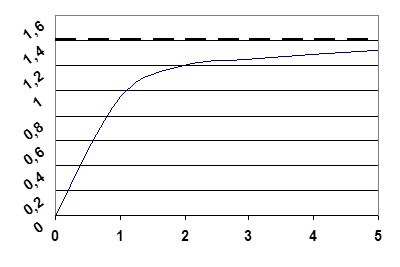

При увеличении F пропускная способность С, бит/с, сначала быстро возрастает, а затем асимптотически стремится к пределу:

C∞

=Lim(Pc/N0

)*loge (10)

Результат (10) получается очень просто, если учесть, что при |e|<<1 ln(1+e)»e. Зависимость С и F показана на рис.4.

F N0

/Pc F N0

/Pc

рис.4 Зависимость нормированной пропускной способности гауссовского канала от его полосы пропускания.

Теорема кодирования для канала с помехами.

Это основная теорема кодирования К. Шеннона. Применительно к дискретному источнику информации она формулируется так:

Теорема

. Если производительность источника сообщений H

’(A

) меньше пропускной способности канала С

: H

’(A

)<С

, то существует такой способ кодирования (преобразования сообщения в сигнал на входе канала) и декодирования (преобразования сигнала в сообщение на выходе), при котором вероятность ошибочного декодирования и ненадежность канала H

(A

|A

*

) могут быть сколь угодно малы. Если же H

’(A

)>С

, то таких способов кодирования и декодирования не существует.

Модель:

Н(А) Н’(В) Н(А) Н’(В)

Н’(А)<с Если же Н’(А)>с, то такого кода не существует.

Теорема указывает на возможность создания помехоустойчивых кодов.

Н’(А)< Н’(В)

Н’(В)=Vk

H

Декодер выдаёт на код каналов Vk

символов в секунду. Если в канале потерь нет, то Vk

=с.

При Н<1 будет тратится больше одного бита на символ, значит появляется избыточность, т.е. не все символы несут полезную информацию.

Делаем вывод, что смысл теоремы Шеннона заключается в том, что при H

’(A

)>С

невозможна безошибочная передача сообщений по данному каналу, если же H

’(A

)<С

, то ошибки могут быть сведены к сколь угодно малой величине. Таким образом, величина С

- это предельное значение скорости безошибочной передачи информации по каналу

Практическая часть.

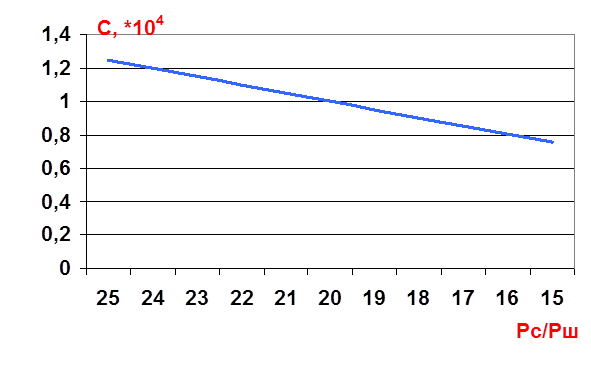

Пропускная способность гауссовского канала определяется [1, стр.118]:

.

Отношение сигнал/шум падает по условию задания с 25 до 15 дБ. Поэтому С также будет уменьшаться. Необходимо уменьшать С/Ш с 25 до 15 дБ с шагом 1 дБ и вычислить по формуле 11 значений С. При этом надо учесть, что в формуле отношение С/Ш - P

c

/P

ш

- дано в разах, поэтому данные в дБ необходимо пересчитать в разы: ; отсюда .

С помощью программы MathCAD получили результаты подсчётов:

С1

=1,246*104

бит/с

С2

=1,197*104

бит/с

С3

=1,147*104

бит/с

С4

=1,098*104

бит/с

С5

=1,048*104

бит/с

С6

=9,987*103

бит/с

С7

=9,495*103

бит/с

С8

=9,003*103

бит/с

С9

=8,514*103

бит/с

С10

=8,026*103

бит/с

С11

=7,542*103

бит/с

Производительность кодера H

’(B

)=v

к

*H

(B

) должна быть меньше пропускной способности канала С, иначе неизбежны потери информации в канале. Максимальное значение энтропии двоичного кодера H

max

=H

(B

)=log2=1 бит. Если С уменьшается, то для избежания потерь информации можно уменьшать H

(B

) так, чтобы H

’(B

) оставалась все время меньше С. Если же H

(B

)<1, это означает, что кодовые символы не равновероятны и зависимы друг от друга, т.е. используется избыточный (помехоустойчивый) код. Избыточность этого кода вычисляется по формуле:

. (11)

Итак, пропускная способность канала С определяет предельное значение производительности кодера H

’(B

): H

’(B

)<C. Отсюда находим предельное значение энтропии кодера:

По условию Vk

=8*103

сим/с

В численном виде это выглядит так:

С/Vk

1=1,558 бит/сим

С/Vk

2=1,496 бит/сим

С/Vk

3=1,434 бит/сим

С/Vk

4=1,372 бит/сим

С/Vk

5=1,31 бит/сим

С/Vk

6=1,248 бит/сим

С/Vk

7=1,187 бит/сим

С/Vk

8=1,125 бит/сим

С/Vk

9=1,064 бит/сим

С/Vk

10=1,003 бит/сим

В этих случаях энтропию Н(В) можно брать любой, вплоть до максимальной (Hmax

=1 бит/сим).

С/Vk

11=0,943 бит/сим

Т.к. в 11-ом случае условие H

’(B

)<C не выполняется, то теорема Шеннона так же не выполняется. Для того чтобы избежать потерь информации, вводим избыточные символы.

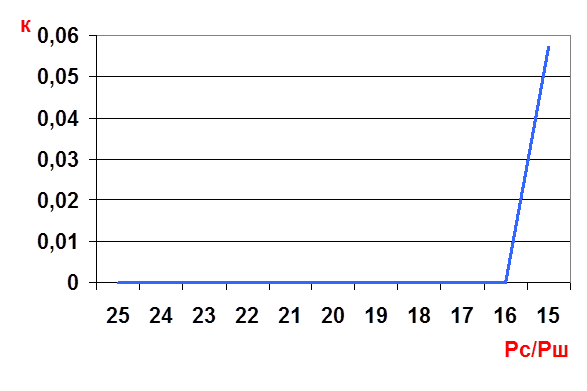

Следующим шагом будет вычисление избыточности κ кода, по формуле (11):

κ=0,057

Чтобы было более наглядно, построим графики зависимостей с=f(Pc

/Pш

) и κ= f(Pc

/Pш

).

График зависимости с=f(Pc

/Pш

) :

График зависимости κ= f(Pc

/Pш

).

Заключение.

В результате проведённой работы, мы можем сделать вывод, что с уменьшением отношения сигнал/шум пропускная способность канала также уменьшается, что приводит к потери информации. Для того чтобы избежать возникновение ошибок, мы вводили избыточные символы. Избыточность этого кода κ=0,057.

Сделаем вывод, что в результате проведенного расчета поставленная задача была полностью решена.

Литература.

1. Зюко А.Г., Кловский Д.Д. и др. Теория передачи сигналов. -М.: Радио и Связь, 1986.

2. Кловский Д.Д., Шилкин В.А. Теория электрической связи. -М.: Радио и связь, 1990.

3. Методическое пособие по курсовой работе ТЭС.

|