| Содержание.

1.

Введение.

2.

Что измерил Клод Шеннон?

3.

Пределы эволюционной изменчивости информационных систем.

4.

Ограниченность адаптации биологических видов.

5.

Этапы развития теории энтропии.

6.

Методы исчисления количества структурной информации и информационной энтропии текстов.

7.

Информационно-энтропийные соотношения процессов адаптации и развития.

8.

Информация и энергия.

9.

Заключение.

10.

Список литературы.

ВВЕДЕНИЕ

Во второй половине XX века произошли два события, которые, на наш взгляд, в значительной мере определяют дальнейшие пути научного постижения мира. Речь идет о создании теории информации и о начале исследований механизмов антиэнтропийных процессов, для изучения которых синергетика привлекает все новейшие достижения неравновесной термодинамики, теории информации и общей теории систем.

Принципиальное отличие данного этапа развития науки от предшествующих этапов заключается в том, что до создания перечисленных направлений исследований наука способна была объяснить лишь механизмы процессов, приводящих к увеличению хаоса и возрастанию энтропии. Что касается разрабатываемых со времен Ламарка и Дарвина биологических и эволюционных концепций, то они и по сей день не имеют строгих научных обоснований и противоречат Второму началу термодинамики, согласно которому сопровождающее все протекающие в мире процессы возрастание энтропии есть непременный физический закон.

Заслуга неравновесной термодинамики заключается в том, что она сумела выявить механизмы антиэнтропийных процессов, не противоречащих Второму началу термодинамики, поскольку локальное уменьшение энтропии внутри самоорганизующейся системы всегда оплачивается большим по абсолютной величине возрастанием энтропии внешней среды.

Важнейшим шагом на пути постижения природы и механизмов антиэнтропийных процессов следует введение количественной меры информации. Первоначально эта мера предназначалась лишь для решения сугубо прикладных задач техники связи. Однако последующие исследования в области физики и биологии позволили выявить универсальные меры, предложенные К.Шенноном, позволяющие установить взаимосвязь между количеством информации и физической энтропией и в конечном счете определить сущность новой научной интерпретации понятия «информация» как меры структурной упорядоченности самых разнообразных по своей природе систем .

Используя метафору, можно сказать, что до введения в науку единой информационной количественной меры представленный в естественно-научных понятиях мир как бы «опирался на двух китов»: энергию и вещество. «Третьим китом» оказалась теперь информация, участвующая во всех протекающих в мире процессах, начиная от микрочастиц, атомов и молекул и кончая функционированием сложнейших биологических и социальных систем.

Естественно, возникает вопрос: подтверждают или опровергают эволюционную парадигму происхождения жизни и биологических видов новейшие данные современной науки?

Для ответа на этот вопрос необходимо прежде всего уяснить, какие именно свойства и стороны многогранного понятия «информация» отражает та количественная мера, которую ввел в науку К.Шеннон.

Использование меры количества информации позволяет анализировать общие механизмы информационно-энтропийных взаимодействий, лежащих в основе всех самопроизвольно протекающих в окружающем мире процессов накопления информации, которые приводят к самоорганизации структуры систем.

Вместе с тем информационно-энтропийный анализ позволяет выявить и пробелы эволюционных концепций, представляющих собой не более чем несостоятельные попытки сведения к простым механизмам самоорганизации проблему происхождения жизни и биологических видов без учета того обстоятельства, что системы такого уровня сложности могут быть созданы лишь на основе той информации, которая изначально заложена в предшествующий их сотворению план.

Проводимые современной наукой исследования свойств информационных систем дают все основания утверждать, что все системы могут формироваться только согласно спускаемым с верхних иерархических уровней правилами, причем сами эти правила существовали раньше самих систем в форме изначального плана (идеи творения).

ЧТО ИЗМЕРИЛ КЛОД ШЕННОН?

В основу теории информации положен предложенный К.Шенноном метод исчислений количества новой (непредсказуемой) и избыточной (предсказуемой) информации, содержащейся в сообщениях, передаваемых по каналам технической связи.

Предложенный Шенноном метод измерения количества информации оказался настолько универсальным, что его применение не ограничивается теперь узкими рамками чисто технических приложений.

Вопреки мнению самого К.Шеннона, предостерегавшего ученых против поспешного распространения предложенного им метода за пределы прикладных задач техники связи, этот метод стал находить все более широкое примение в исследованиях и физических, и биологических, и социальных систем .

Ключом к новому пониманию сущности феномена информации и механизма информационных процессов послужила установленная Л.Бриллюэном взаимосвязь информации и физической энтропии. Эта взаимосвязь была первоначально заложена в самый фундамент теории информации, поскольку для исчисления количества информации Шеннон предложил использовать заимствованную из статистической термодинамики вероятную функцию энтропии.

Многие ученые (начиная с самого К.Шеннона) склонны были рассматривать такое заимствование как чисто формальный прием. Л.Бриллюэн показал, что между вычисленным согласно Шеннону количеством информации и физической энтропии существует не формальная, а содержательная связь.

В статистической физике с помощью вероятностной функции энтропии исследуются процессы, приводящие к термодинамическому равновесию, при котором все состояния молекул (их энергии, скорости) приближаются к равновероятным, а энтропия при этом стремится к максимальной величине.

Благодаря теории информации стало очевидно, что с помощью той же самой функции можно исследовать и такие далекие от состояния максимальной энтропии системы, как, например, письменный текст.

Еще один важный вывод заключается в том, что

с помощью вероятностной функции энтропии можно анализировать все стадии перехода системы от состояния полного хаоса, которому соответствуют равные значения вероятностей и максимальное значение энтропии, к состоянию предельной упорядоченности (жесткой детерминации), которому соответствует единственно возможное состояние ее элементов.

Данный вывод оказывается в равной мере справедливым для таких несходных по своей природе систем, как газы, кристаллы, письменные тексты, биологические организмы или сообщества и др.

При этом, если для газа или кристалла при вычислении энтропии сравнивается только микросостояние (т.е. состояние атомов и молекул) и макросостояние этих систем (т.е. газа или кристалла как целого), то для систем иной природы (биологических, интеллектуальных, социальных) вычисление энтропии может производится на том или ином произвольно выбранном уровне. При этом вычисляемое значение энтропии рассматриваемой системы и количество информации, характеризующей степень упорядоченности данной системы и равное разности между максимальным и реальным значением энтропии, будет зависеть от распределения вероятности состояний элементов нижележащего уровня, т.е. тех элементов, которые в своей совокупности образуют эти системы.

Другими словами,

количество сохраняемой в структуре системы информации пропорционально степени отклонения системы от состояния равновесия, обусловленного сохраняемым в структуре системы порядком.

Сам того не подозревая, Шеннон вооружил науку универсальной мерой, пригодной в принципе (при условии выявления значенй всех вероятностей) для оценки степени упорядоченности всех существующих в мире систем.

Опредеделив введенную Шеноном информационную меру как меру упорядоченности движения

, можно установить взаимосвязь информации и энергии, считая энергию мерой интенсивности движения

. При этом количество сохраняемой в структуре систем информации пропорционально суммарной энергии внутренних связей этих систем.

Одновременно с выявлением общих свойств информации как феномена обнаруживаются и принципиальные различия относящихся к различным уровням сложности информационных систем.

Так, например, все физические объекты, в отличие от биологических, не обладают специальными органами памяти, перекодировки поступающих из внешнего мира сигналов, информационными каналами связи. Хранимая в них информация как бы «размазана» по всей их структуре. Вместе с тем, если бы кристаллы не способны были сохранять информацию в определяющих их упорядоченность внутренних связях, не было бы возможности создавать искусственную память и предназначенные для обработки информации технические устройства на основе кристаллических структур.

Вместе с тем необходимо учитывать, что создание подобных устройств стало возможным лишь благодаря разуму человека, сумевшего использовать элементарные информационные свойства кристаллов для построения сложных информационных систем.

Простейшая биологическая система превосходит по своей сложности самую совершенную из созданных человеком информационных систем. Уже на уровне простейших одноклеточных организмов задействован необходимый для их размножения сложнейший информационный генетический механизм. В многоклеточных организмах помимо информационной системы наследственности действуют специализированные органы хранения информации и ее обработки (например, системы, осуществляющие перекодирование поступающих из внешнего мира зрительных и слуховых сигналов перед отправкой их в головной мозг, системы обработки этих сигналов в головном мозге). Сложнейшая сеть информационных коммуникаций (нервная система) пронизывает и превращает в целое весь многоклеточный организм.

Уже на уровне биологических систем возникают проблемы учета ценности и смысла используемой этими системами информации. Еще в большей мере такой учет необходим для ананлиза функционирования интеллектуальных информационных систем.

Глубокое осознание специфики биологических и интеллектуальных систем позволяет выявить те границы, за пределами которых утрачивает свою компетентность разработанный современной наукой информационно-энтропийный подход.

Определить эти границы Шеннону пришлось на самом начальном этапе создания теории информации, поскольку без этого нельзя было использовать количественную меру информации для оценки письменных текстов и других созданных разумом человека информационных систем. Именно с этой целью Шеннон делает оговорку о том, что предложенный им метод исчисления информации письменных текстов игнорирует такие же их неотъемлемые свойства, как смысл и ценность содержащихся в них сообщений.

Так, например, при подсчете количества информации, содержащейся в таких двух сообщениях, как «очередную партию Каспаров играет белыми»

и «у гражданина Белова родился сын»

получится одна и та же величина – 1 бит. Нет сомнения, что два этих сообщения несут разный смысл и имеют далеко не равнозначную ценность для гражданина Белова.

Однако, как было отмечено выше, оценка смысла и ценности информации находится за пределами компетенции теории информации и поэтому не влияет на подсчитываемое с помощью формулы Шеннона количество бит.

Игнорирование смысла и ценности информации не помешало Шеннону решать прикладные задачи, для которых предназначалась первоначально его теория: инженеру по технике связи вовсе не обязательно вникать в суть сообщений, передаваемых по линии связи. Его задача заключается в том, чтобы любое подобное сообщение передавать как можно скорее, с наименьшими затратами средств (энергии, диапазона используемых частот) и, по возможности, безо всяких потерь. И пусть тот, кому предназначена данная информация (получатель сообщений), вникает в смысл, определяет ценность, решает, как использовать ту информацию, которую он получил.

Такой сугубо прагматичный подход позволил Шеннону ввести единую, не зависящую от смысла и ценности, меру количества информации, которая оказалась пригодной для анализа всех обладающих той или иной степенью упорядоченности систем.

После основополагающих работ Шеннона начали разрабатываться основы смысловой (семантической) и ценностной (прагматической, аксиологической) информационных теорий .

Однако ни одной из этих теорий и предлагаемых их авторами единиц измерения ценности или смысла не суждено было приобрести такую же степень универсальности, какой обладает мера, которую ввел в науку Шеннон.

Дело в том, что количественные оценки смысла и ценности информации могут производится только после предварительного соглашения о том, что же именно в каждом конкретном случае имеет для рассматриваемых явлений ценность и смысл. Нельзя одними и теми же единицами измерить ценность информации, содержащейся, скажем, в законе Ома и в признании любви. Иными словами, критерии смысла и ценности всегда субъективны, а потому применимость их ограничена, в то время как мера, предложенная Шенноном, полностью исключает субъективизм при оценке степени упорядоченности структуры исследуемых систем.

Так что же характеризует подсчитанная по формуле Шеннона величина энтропии текста, выражаемая количеством бит? Только лишь одно свойство этого текста - степень его упорядоченности или , иными словами, степень его отклонения от состояния полного хаоса, при котором все буквы имели бы равную вероятность, а текст превратился бы в бессмысленный набор букв.

Упорядоченность текста (или любой другой исследуемой системы) будет тем больше, чем больше различие вероятностей и чем больше вероятность последующего события будет зависеть от вероятностей предыдущих событий[1]

. При этом,

согласно негэнтропийному принципу информации количество информации, выражающее этот порядок, будет равно уменьшению энтропии системы по сравнению с максимально возможной величиной энтропии, соответствующей отсутствию упорядоченности и наиболее хаотичному состоянию систем.

Методы исчисления информации, предложенные Шенноном, позволяют выявить соотношение количества предсказуемой (то есть формируемой по определенным правилам) информации и количества той неожиданной информации, которую нельзя заранее предсказать.

Содержащуюся в правилах информацию Шеннон определил как избыточную, потому что знание правил построения сообщений позволяет предсказывать появление букв (или других символов) раньше, чем они будут сообщены по линии связи.

Таким способом удается в той или иной степени «разгрузить» предназначенный для передачи сообщений канал. Проведенный Шенноном анализ английских текстов показал, что содержащаяся в них избыточная информация составляет около 80% от общего количества информации, которое заключает в себе письменный текст. Остальные 20% - это та самая энтропия, благодаря которой текст может служить источником непредсказуемой энергии [2]

.

Если бы текстовые, устные или зрительные (в частности телевизионные) сообщения были полностью лишены энтропии, они не приносили бы получателям сообщений никаких новостей.

Если бы письменный текст строился только на основании заранее сформулированных правил , то, установив эти правила по тексту первой страницы, можно было бы заранее предсказать, что будет написано на страницах 50, 265, 521 и т.д.

ПРЕДЕЛЫ ЭВОЛЮЦИОННОЙ ИЗМЕНЧИВОСТИ ИНФОРМАЦИОННЫХ СИСТЕМ

Наиболее наглядной иллюстрацией информационно-энтропийных закономерностей и ограничений эволюционных процессов может служить письменный текст. А поскольку текст есть не что иное, как закодированное отражение устной речи, имеет смысл в дальнейшем вести речь об эволюции языка.

Примерами эволюционных изменений языка могут служить, в частности, образование неологизмов, заимствование иностранных слов и др.

Приобщение бывших социалистических стран к международному рынку сопровождалось ассимиляцией таких терминов, как «менеджмент», «маркетинг», «дилер» и т.п. С переходом к парламентским формам управления государством в бывших социалистических странах приобрели популярность такие понятия, как «консенсус» и «плюрализм».

Процесс вовлечения в лексикон новых слов имеет ряд существенных ограничений. Необходимым условием ассимиляции иностранных слов оказывается адаптация этих слов к новой языковой среде. При включении иностранного слова в лексикон нового языка, слово это должно подчиняться действующим в этом языке правилам согласования слов (т.е. правилам склонения, сопряжения и др.). Подобная адаптация аналогична процессам обучения живых организмов правилам поведения в необычной для них среде.

В свою очередь правила согласования слов подчиняются требованиям, возникающим на еще более высоких уровнях языковой структуры.

Эти требования зависят прежде всего от смыслового содержания текста, от стиля, присущего составителю, данного текста и, наконец, от всего набора грамматических и фонетических правил данного языка.

Например, слово спутник

было введено в русский язык Достоевским. Из бытовой сферы («спутник жизни») это слово распространилось в область астрономии («Луна – спутник Земли») и стало международным словом после того, как в Советском Союзе был запущен первый искусственный спутник Земли. Однако, при всех трансформациях смысла форма этого слова определялась правилами грамматики, установленными вместе с возникновением языка. Об этом свидетельствует совпадение структуры слова с-пут-ник

с такими аналогами, как со-рат-ник

и со-племен-ник

, образованными от корней древних слов племя

и рать

.

С биологическим и видами тоже могут происходить аналогичные метаморфозы. В результате мутаций может родиться заяц, у которого уши будут короче, чем у собратьев, или его шерстяной поркров приобретет необычный цвет. Эти признаки он передаст по наследству, быть может, они закрепятся в потомстве, но при этом потомки нашего зайца тоже останутся зайцами, но ни в коем случае не превратятся в волка или лисицу и, уж тем более, не примкнут к отряду приматов. Подобно тому, как структура нового слова «спутник» совпадает со структурой древних слов «соратник» и «соплеменник», внутренняя и внешняя структура организма современного зайца повторяет структуру зайца, появившегося в результате акта творения на нашей Земле.

Мутациям могут подвергаться только второстепенные признаки, а основные признаки вида остаются неизменными, подобно тому, как в приведенных выше примерах словообразований неизменными остаются определяющие смысловое значение каждого слова корни путь, племя и рать. При этом могут меняться второстепенные признаки слова (префиксы, суффиксы, окончания), превращая путь в спутник, попутчик, путевой, путевка, распутица, беспутный, путеводный и т.п.

Изначальный смысл слова путь при этом всюду останется неизменным, а основанные на коренном слове словообразования могут приобретать те или иные оттенки в процессе последующей эволюции языка.

Каждое новое слово подчиняется правилам, сохраняемым на высоких иерархических уровнях информационно-энтропической спирали и действующим сверху вниз и на уровне слов, и на уровне букв.

Подобным образом мог быть сформирован и живой организм. Правила, которым подчиняются все его согласованно функционирующие органы, ткани и клетки, могли быть «сформулированы» только на самых высоких, не доступных нашему разуму уровнях информационно-энтропической спирали.

Приведенная в таблице 1

«фраза», полученная в результате случайного комбинирования 8-и буквенных сочетаний, имеет формальные признаки осмысленных фраз. В ней можно различить глагольные формы (враться), наречия (непо и корко), форму прилагательного (весел) и даже уловить некий опенок смысла (какого-то бодрого действия, движения).

В свое время академик Щерба тоже приводил пример формализированной фразы, из которой можно было бы понять, что некая Глокая куздра штекобуданула (читай: «оттолкнула») некого «бокра» и кудрячит (читай: «приласкивает») бокренка.

Означают ли две рассмотренные «фразы», что при движении снизу вверх по рассматриваемой нами спирали, можно путем случайных комбинаций букв и слогов получить осмысленный текст? Такой вывод был бы ошибочным. Формальное сходство с грамматическими конструкциями порождает всего лишь иллюзию смысла, потому что не смысл рождается из грамматики, а грамматика строится таким образом, чтобы с ее помощью можно было передать (т.е. закодировать) содержащийся в той или иной фразе смысл.

Таким образом, эти примеры еще раз убеждают нас в том, что план построения сложной информационной системы может формироваться только на верхних иерархических уровнях и оттуда спускаться на нижележащие уровни, задавая на них тот или иной порядок чередования элементов.

Сказанное выше имеет самое непосредственное отношение к проблеме возникновения и функционирования биологических систем.

Выше было отмечено, что проводимый на самом нижнем структурном уровне текста (на уровне отдельных букв) статистический анализ распределения вероятностей букв и последующий расчет количества информации и величины энтропии способны регулировать лишь результирующую упорядоченность текста. Причины этой упорядоченности формируются на недоступных информационно-энтропийному анализу верхних иерархических уровнях текста и языка.

Пытаясь преодолеть указанные ограничения возможностей информационно - энтропийного анализа, К.Шеннон исследовал вероятности появления в тексте различных 4-х, 6-ти и 8-ми буквенных сочетаний. Подставляя найденные значения вероятностей в вероятную функцию энтропии, К.Шеннон определил таким образом величину энтропии с учетом взаимной зависимости (корреляции) букв в пределах слогов, а затем экстраполировал полученный результат на более длительные текстовые отрезки, показав, что корреляция не выходит за пределы отрезков текста в 40-60 букв .

Аналогичные результаты исследований русских текстов представлены в работе Добрушина (табл. 1).

Используемый теорией информации полуэмпирический метод учета межбуквенных корреляций обладает рядом существенных ограничений, которые становятся очевидными, если сопоставить результаты анализа искусственных текстов Шеннона со свойствами реального языка. Дело в том, что при искусственном расчленении текста на отрезки из 4-8 букв стираются границы, разделяющие уровни слогов от уровней слов. В реальных текстах в зависимости от смыслового контекста и одна, и две, и три буквы могут быть в одних случаях самостоятельным словом, а в других – входить в состав других слов.

Очевидно, что в двух указанных случаях рассматриваемые сочетания букв относятся к различным иерархическим уровням текста (или к уровню слогов), однако подобное разграничение уровней может осуществляться только по смыслу, который заключает в себе анализируемый текст. А поскольку используемые теорией информации методы игнорируют смысловое содержание текста, исследуемые ею искусственные тексты отличаются от реальных текстов отсутствием четкой иерархической структуры.

Причины возникновения исследуемого порядка всегда остаются за пределами компетенции статистических методов. Находясь как бы на нижних ступенях некой упорядоченной иерархической структуры, вооруженная статистическими методами наука исследует не само действие порождающих исследуемый порядок причин, а лишь его результат. Любая попытка с помощью информационно-энтропийного анализа делать какие бы то ни было выводы о содержательной стороне письменных текстов была бы равносильна суждению о достоинствах и недостатках какого-то музыкального произведения на основании того, как часто создававший его композитор прибегал к помощи ноты «до» или «соль». Подобным способом можно идентифицировать принадлежность тому или иному автору его сочинений, но бесполезно пытаться по результатам такого анализа доискиваться до причин, побудивших этого автора сочинить именно эту симфонию, поэму или роман.

Из всего вышесказанного следует, что адекватное представление об иерархической структуре реальных текстов не может быть получено на основании конструирования искусственных текстов, осуществляемого теорией информации по принципу «снизу вверх».

Присущий реальным текстам порядок чередования букв формируется согласно правилам, заданным верхними иерархическими уровнями текста, то есть не «снизу вверх», а «сверху вниз». Что же касается используемой теорией информации вероятностной функции энтропии, то она может быть использована в качестве точного математического инструмента только на нижних уровнях иерархии текста, поскольку только на этих уровнях удается найти достоверные значения вероятностей появления исходных элементов этого уровня (т.е. букв). С переходом на следующий уровень мы обнаруживаем такое обилие исходных элементов этого уровня (т.е. такое количество слов), что определение вероятности появления в тексте всех слов, составляющих лексикон, становится практически неразрешимой задачей.

Так, например, лексикон искусственного текста, каждое слово которого состоит из 6-ти букв, а алфавит - из 30-ти букв, составит 306

= 729 • 106

«слов». Среди этих слов будут попадаться бессмысленные и даже непроизносимые сочетания из 6-ти гласных или 6-ти согласных букв.

Приняв, что значащие слова составят 0,01% от всех шестибуквенных комбинаций, получим 72 900 слов. Из сочетаний этих слов можно составить практически неограниченное количество текстов, поэтому бессмысленно пытаться определять вероятности появления отдельных слов.

Это значит, что вероятностная функция энтропии не может быть использована для строгого определения количества информации и энтропии текстов на уровне слов, и поэтому Шеннон был вынужден использовать приближенные методы экстраполяции результатов, полученных на уровне слогов и отдельных букв.

Четкое понимание присущих информационно-энтропийному анализу ограничений не исключает возможности использования полученной нами на примере искусственных текстов расширяющейся информационно-энтропийной спирали (рис. 3

) в качестве универсальной модели всех существующих в мире иерархических систем. Благодаря теории информации, понятие «текст» приобретает общенаучный смысл.

Так, например, начальным алфавитом всех генетических кодов служат

4 нуклеотида ДНК. Генетический «лексикон» состоит из триплетов, соответствующих 20-ти аминокислотам. Содержащиеся в генах «фразы» – это закодированные программы формировния органов и их функций, «концепция» – это целостный организм.

«Начальным алфавитом» всей природы служат входящие в менделеевскую таблицу атомы химических элементов. «Лексикон» – это молекулы сложных веществ. «Фразы, концепции» – это геохимические и биологические системы, составляющие все многообразие и богатство природы.

Так же, как в случае текста, за пределами когнитивных возможностей иерархической информационно-энтропийной модели остаются вопросы о том, на каких высших уровнях и каким образом формируются правила, определяющие фиксируемую наукой на более низких уровнях упорядоченность структуры существующих в природе систем.

Как будет показано ниже, этот вопрос приобретает особую актуальность, когда речь заходит о происхождении, адаптации и эволюционной изменчивости биологических видов.

Используя текст в качестве универсальной модели, можно установить те пределы изменчивости, в которых может осуществляться самоорганизация и адаптация биологических систем. С учетом выявленных ограничений можно выявить ошибочность основных положений отстаиваемой материалистической наукой концепции происхождения и эволюции биологических видов.

ОГРАНИЧЕННОСТЬ АДАПТАЦИИ БИОЛОГИЧЕСКИХ ВИДОВ

Рассмотренные механизмы ограничения эволюционной изменчивости языковых форм могут использоваться в качестве наглядной аналогии при постижении скрытых от постороннего взгляда механизмов изменчивости биологических видов. Одним из классических примеров такой изменчивости может служить адаптация одного из видов бабочек (пяденицы березовой) к нарушенным индустриальными факторами условиям среды их обитания в районе Манчестера и других промышленных центров Англии прошлого века. В результате загрязнения лесов копотью начал исчезать светлый лишайник, ранее покрывавший стволы деревьев. В результате адаптации к новым условиям наряду с бабочками, обладавшими маскирующей на фоне лишайников светлой окраской крыльев, появились популяции с темной окраской крыльев, приспособленной для маскировки на лишенных лишайников темных стволах. По произведенным оценкам относительное количество бабочек с темными крыльями в популяции выросло с 1% в 1848 году до 99% в 1898 году. Можно ли данный факт рассматривать как подтверждение эволюционной теории? Да, если считать эволюцией любое

изменение признаков под влиянием внешней среды. Нет, если, следуя логике сторонников эволюционной теории, под эволюцией понимать тенденцию самопроизвольного формирования более сложных биологических форм.

Пяденица березовая не перестала быть бабочкой после того, как изменился цвет ее крыльев. Точно так же, как заяц никогда не превратится в лису или волка, амеба не породит многоклеточных организмов, а обезьяны не смогут стать предками разумных людей.

Эволюционные изменения признаков биологических форм осуществляются только в пределах, не нарушающих основных признаков данного вида, то есть в пределах горизонтальной плоскости иерархической информационной модели, соответствующей неизменному уровню иерархической структуры.

Вместе с тем, пример пяденицы березовой вовсе не подтверждает возможности эволюции по вертикали, то есть в направлении перехода на более высокие уровни иерархической структуры и соответствующего самопроизвольного усложнения биологических форм. Напротив, имеющиеся в распоряжении биологов факты свидетельствуют о том, что в акте творения были изначально предусмотрены правила, ограничивающие возможности изменений видовых и родовых признаков и таким образом обеспечивающие устойчивость к воздействиям внешней среды.

К числу правил относятся защищенность от внешних воздействий наследственных генетических кодов и запреты на межвидовые и межродовые скрещивания, которые могли бы приводить к образованию гибридных пород.

Даже в тех случаях, когда межвидовые скрещивания оказываются возможными, возникают особи, почти не способные производить потомство. Так, например, в результате скрещивания ослицы и жеребца в редких случаях удается получить гибридную особь (лошака). Более продуктивным оказывается скрещивание кобылы с ослом, однако при этом почти бесплодными оказываются их потомки (мулы).

Рассмотренные примеры свидетельствуют о том, что в противовес утверждениям эволюционистов уже сама идея творения заключала в себе условия последующего сохранения основных признаков биологических форм. По аналогии с информационными свойствами письменных текстов можно предполагать, что эти основные и неизменные признаки вида составляют порядка 80% информации, заключенной в наследственных генетических кодах. Остальные 20% - это те второстепенные признаки, котрые видоизменяются под воздействием внешней среды.

Всякая аналогия, в том числе и аналогия свойств генетических и письменных текстов, является приближенной, поэтому приведенные цифры (80% и 20%) могут характеризовать лишь примерное соотношение сохраняемых и изменяющихся признаков тех или иных биологических форм. Тем не менее даже чисто интуитивные оценки дают основания предполагать, что соотношение 80/20 должно соблюдаться в действительности : чтобы курица не превращалась в утку, она должна сохранить около 80% признаков своего вида, а 20% включают в себя изменение цвета перьев, размеров гребешка или клюва и т.п.

Имеющиеся научные данные подтверждают возможность адаптационных изменений второстепенных признаков при условии сохранения тех основных признаков, по которым осуществляется различение биологических форм. Источник указанных ограничений находится на недоступных рациональной науке самых высоких уровнях иерархической информационной структуры. Если за нижний уровень иерархии информационно-энтропической модели принять неорганические системы, то следующую ступень иерархической лестницы следует соотнести с биологическими системами.

Над ними находится следующий уровень более сложно организованных интеллектуальных систем. А самым высоким оказывается тот недоступный рациональному постижению уровень (логос), на котором и формируются правила, которым подчиняются все нижележащие уровни, то есть весь доступный нашим наблюдениям мир.

В сопоставлении с таким представлением об информационной структуре мира становится особенно очевидной наивность попыток Дарвина и его последователей объяснить эволюционное происхождение биологических видов в результате отбора тех особей, преимущества которых возникли в результате чисто случайных причин.

Критики теории Дарвина утверждали, что случайная изменчивость способна только нарушить изначальную целостность организма как слаженно функционирующей системы. В результате снижается их адаптация по отношению к условиям существования, а следовательно, уменьшаются шансы на закрепление эти случайно возникших признаков в последующих поколениях.

В ответ на подобную критику и сам Дарвин, и его последователи обычно ссылались на длительность сроков биологической эволюции, которая, по их утверждениям, исчисляется миллиардами лет. Неубедительность подобной аргументации можно проиллюстрировать следующим наглядным примером.

Представим себе, что некий доморощенный «изобретатель», не имеющий никаких представлений ни о принципах телевидения, ни о схеме имеющейся в его распоряжении конкретной модели, решил, что он сможет получить дополнительные телеканалы путем случайной перепайки концов внутренних проводов. Чем больше времени будетдлиться подобная процедура, тем труднее будет возвратить в рабочее состояние телевизор, над которым произведен подобный эксперимент.

А ведь не только телевизор, но даже и самый совершенный из современных компьютеров в отношении сложности не может идти ни в какое сравнение с представителями даже самых простейших биологических форм. Ведь не случайно даже самый сложный компьютер после отказа поддается восстановлению, а любой живой организм после нарушения его жизненных функций еще никто из людей не сумел «оживить».

Длительный срок эволюции не может служить аргументом, подтверждающим возможность случайного возникновения ни новых полезных признаков, ни, тем более, новых сложных и совершенных биологических форм.

Биосистемы настолько сложны по своей структуре и функциям, что есть все основания предполагать, что все иерархические уровни их структуры могут вносить свою лепту в процессы упорядоченного функционирования и адаптационных изменений этих систем.

Об этом свидетельствуют, в частности, результаты новейших исследований в области неравновесной термодинамики, исследующей механизмы процессов самоорганизации неорганических систем.

Оказалось, что в системе, еще находящейся в состоянии равновесия, которому соответствует предельный хаос движения молекул и атомов, уже заложены потенциально так называемые атракторы – различные варианты структур. Реализация этих структур произойдет только в том случае, если какие-то внешние факторы заставят систему отклониться от равновесного состояния, а затем случайные флуктуации направят процесс по одному из заранее обусловленных путей .

И тут опять возникает вопрос, на который рациональная наука не в состоянии дать ответ: кем же выбраны именно эти структуры? Кто запретил в точках так называемых бифуркаций одни варианты формирующейся структуры, но разрешил другие? Кто заложил структурные признаки симметрии и асимметрии, одни и те же, или весьма сходные и для неорганических, и для живых систем ?

Еще раз подчеркнем, что, проводя исследования на различных иерархических уровнях информационно-энтропийной спирали (т.е. на уровне неорганических, биологических, интеллектуальных систем), наука способна фиксировать лишь сами процессы функционирования различных информационных структур, оставляя за скобками вопросы о том, почему они функционируют именно так, а не иначе, где и как формируются правила, согласно которым в результате координированного взаимодействия всех структурных уровней иерархической спирали функционирует сложнейшая система -живой организм.

Сам собой напрашивается вывод, что эти правила могут формироваться только на уровне Логоса, откуда они транслируются на все нижележащие уровни и обеспечивают их согласованное функционирование и ту гармонию, которой обладает всякий живой организм.

В поисках истоков этой гармонии некоторые ученые-эволюционисты готовы признать правомерность телеологических эволюционных концепций . Но если у эволюции биологических форм есть какие-то конечные цели, то они были заданы изначально не кем иным, как Творцом не только всех биологических форм, но и всей биосферы как цельного, гармонично функционирующего компонента земного мира.

Не находит в науке ответа также вопрос о том, что может служить стимулом самопроизвольного усложнения организмов, то есть движения по ступеням иерархической лестницы от одноклеточных к многоклеточным, от прокариот к эукариотам, от беспозвоночных к позвоночным и т.д. Борьба за существование не может служить объяснением подобных тенденций, поскольку в отношении выживаемости постейшие организмы не уступают сложнейшим. Здесь приходится согласиться с известным английским публицистом Сэмом Батлером, сказавшим однажды, что ни одна теория эволюции не отвечает на вопрос, почему развитие биосистем должно идти в направлении не от слона к амебе, а от амебы к слону.

ЭТАПЫ РАЗВИТИЯ ТЕОРИИ ЭНТРОПИИ

1а

. Функция энтропии была введена в термодинамику Р.Клаузиусом, предложившим исчислять превращение энтропии по формуле:

где S

- энтропия ;

Q

-

количество тепла ;

Т

- абсолютная температура .

При передаче тепла D

Q

от более разогретого тела с температурой Т1

к менее разогретому телу с температурой Т2

превращение

энтропии D S равно:

D

S =

|

-

D

Q

|

+

|

+

D

Q

|

(1.2)

|

| T

1

|

T2

|

Из формулы (1.2)

с учетом условия T1

> T2

следует вывод :

Поскольку во всех физических процессах тепло перетекает самопроизвольно от более разогретых к менее разогретым телам, условие (1.3)

приобретает силу физического закона, получившего название Второго начала термодинамики.

Пока существует разность температур T1

– T2

,

часть теплового потока может быть преобразована в полезную (антиэнтропийную) энергию либо в естественно протекающих процессах (например, биологических), либо с помощью тепловых машин.

При условии T1

= T2

энергия полностью утрачивает свои антиэнтропийные свойства. Этот вывод был положен в основу теории тепловой смерти Вселенной.

Заметим, что сам термин «энтропия» был введен Клаузиусом, образовавшим его от корня греческого слова «тропе», означающего «превращение» с добавлением заимствованной из слова «энергия» приставки «эн-».

1б

.

Предложенная Клаузиусом формула энтропии (1.1)

не раскрывала внутренних механизмов процессов, приводящих к возрастанию энтропии.Эта задача была решена Л.Больцманом, предложившим исчислять энтропию идеального газа по формуле :

где K=

1,38

· 10 -16

эрг

/градус

– коэффициент Больцмана

Н -

математическая энтропия.

Согласно Больцману, величина H

определяется так :

H = ln

|

N !

|

(1.

5

)

|

| N1

! N2

! … Nk

!

|

где N

- общее число молекул газа, находящегося в рассматриваемом объеме.

Ni

-

число молекул, движущихся со скоростями, соответствующими i

-ой ячейке условного пространства скоростей.

При этом 1= 1,2, ...

К

( 1.6)

Условие (1.6)

означает, что все N

молекул распределены по соответствующим ячейкам пространства скоростей, в количествах N1

, N2

, … Nk

,

,

учитываемых уравнением (1.5)

Согласно (1.5)

перестановка молекул, находящихся внутри каждой из ячеек, не влияет на величину Н .

Отсюда следует, что подсчитанная по формуле (1.5)

величина Р

соответствует числу возможных микросостояний системы (в частности газа), при котором макросостояние системы остается неизменным.

1в

.

М.Планк преобразовал формулу Больцмана (1.5),

использовав для этого математическую формулу Стирлинга, справедливую для больших значений N :

| ln(N !) = Nln N – N

|

(1.7)

|

В результате подстановки (1.7)

в (1.5)

получается соотношение :

| H = Nln N – N –(S Ni

ln Ni

– S Ni

)

|

| i

|

i

|

С учетом условия S Ni = N,

выражение для Н

приводится к виду:

| H = Nln N –S Ni

ln Ni

|

(1.8)

|

| i

|

Далее Планк ввел в рассмотрение вероятности различных состояний молекул, определив их как :

При этом второе слагаемое в правой части (1.8)

можно представить как:

| S Ni

ln Ni

=S pi

N ( ln pi

+ ln N ) = N S pi

ln pi

+ N ln N Si

pi

|

(1.10)

|

| i

|

|

i

|

|

i

|

|

i

|

|

С учетом известного из теории вероятностей условия нормировки S

pi

=

1,

подстановка (1.10)

в (1.8)

приводит выражение для Н

к окончательному виду :

Проделанные Планком с помощью формулы Стирлинга чисто формальные преобразования не только позволили получить новое выражение для исчисления энтропии, но помогли более глубоко осознать смысл вычисляемой величины Н .

Выражение (1.11)

позволяет сделать два важных вывода :

1. Введение в формулу энтропии значений вероятностей расширило рамки применимости этой формулы далеко за пределы исследуемых термодинамикой молекулярных систем. Символ pi

может обозначать вероятность не только тех или иных состояний молекул, но и различных состояний элементов любых систем (в частности, вероятностей появления букв текста или других символов передаваемых сообщений).

2. Выражение (1.11) соответствует полной энтропии системы. Поделив подсчитанную по формуле (1.11) величину на Ni , можно определить усредненную величину энтропии Н , относящуюся к одному элементу рассматриваемой системы, т.е.

Именно в таком виде использовал функцию энтропии Шеннон для определения среднего значения энтропии одной буквы текста (опуская при этом знак усреднения).

1г

.

Согласно Шеннону, средняя энтропия одной буквы текста вычисляется по формуле (1.2)

путем суммирования слагаемых pi log pi

,

в

которых символом pi

,

обозначены вероятности соответствующих букв. Таким образом :

| i

=я

|

(1.13)

|

| H = –S pi

ln pi

= - (pа

log pа

+ pб

log pб

+…+ pя

log pя

)

|

| i

=а

|

Для удобства исчисления энтропии сообщений, передаваемых двоичным кодом, Шеннон заменил используемый термодинамикой натуральный логарифм ln

двоичным логарифмом log2

.

МЕТОДЫ ИСЧИСЛЕНИЯ КОЛИЧЕСТВА СТРУКТУРНОЙ ИНФОРМАЦИИ И ИНФОРМАЦИОННОЙ ЭНТРОПИИ ТЕКСТОВ

До опубликования созданной К.Шенноном теории Р.Хартли предложил определять количество информации по формуле :

где I

- количество информации ;

N

- число возможных (ожидаемых) сообщений.

Для учета различной степени неожиданности (вероятности) сообщений К.Шеннон предложил использовать заимствованную из статистической физики вероятностную функцию энтропии, приведенную к виду (1.13)

В случае равной вероятности появления любой из N

букв алфавита выполняется условие:

| Pа

= Pб

= Pв

= … = Pя

= 1/N

|

(2.2)

|

В результате подстановки (2.

2

)

в (2.1)

и с учетом того, что:

- log1/N = + log N

получаем :

| H = – (

|

1

|

log

|

1

|

)=log N

|

(2.3)

|

| N

|

N

|

Сопоставляя (2.

1

)

и (2.3),

приходим к выводу, что количество информации, вычисляемое по формуле Хартли, соответствует устранению неопределенности Н

при получении сообщения об одной из букв алфавита, при условии равной вероятности появления любой из букв (условие 2.2).

При равных вероятностях появления всех букв алфавита текст становится наиболее хаотичным. Подсчитанная по формуле (2.3)

величина информационной энтропии достигает максимальной величины :

За единицу количества информации принята величина информации, содержащейся в сообщении об одном из двух равновероятных событий.

До получения сообщения выполняются условия :

| P1

= P2

=

|

1

|

=

|

1

|

(2.5)

|

| N

|

2

|

При подстановке (2.5)

в (1.13)

получаем :

| H = (½ log2

½ + ½ log2

½) = + log2

2 = 1 bit

|

Наименование «бит» (

“bit”)

происходит от сокращения английских слов «двоичная единица» (bi

nary unit

).

В реальных текстах появлению разных букв соответствуют разные вероятности. Так, например, для русских текстов вероятность появления буквы "О" в 30 раз превышает вероятность появления буквы «Щ» или «Э» (

Ро

= 0,09;

Рщ

= Рэ

= 0,003).

При подстановке в формулу (1.13)

реальных значений вероятностей букв русского текста величина реальной информационной энтропии Н

r

уменьшается по сравнению с максимальной энтропией, определяемой выражением (2.4).

Разность между величиной максимальной энтропии Н

max

и реальной энтропии Н

r

соответствует количеству избыточной (предсказуемой ) информации In

.

Таким образом:

Учет реальных значений вероятностей букв при передаче письменных текстов позволяет уменьшить избыточность сообщений, передаваемых по каналам связи. Так, например, для избавления от избыточности используется способ кодирования букв алфавита, при котором часто повторяющимся в тексте буквам

(т.е. буквам, имеющим наибольшую вероятность, такую, например, как Ра

= =0,062; Рв

= 0,038 ;

Ре

= 0,072 ; Рл

= 0,035 ; Ро

= 0,09

и др.) соответствуют или меньшая трата энергии за счет уменьшения величины (амплитуды) сигналов или, увеличенная скорость передачи за счет сокращения числа знаков двоичного кода, соответствующего обозначению указанных букв.

Помимо учета реальных вероятностей букв, для уменьшения избыточности сообщений следует учитывать также вероятности их сочетаний (например, высокую вероятность появления буквы Я

после переданного сочетания ТЬС ,

малую вероятность появления согласной буквы после передачи следующих друг за другом трех согласных букв и т.п.).

Таблица 1

| Способ формирования «фраз»

|

№№

пп

|

"Фразы", полученные на основе статистических

свойств русского языка

|

Статистические характеристики фраз

|

| Н

r

(бит)

|

D

Is

(бит )

|

| При равной вероятности всех букв

|

1

|

СУХРРОБЬТ ЯИХВЩИЮАЙЖТЛ-ФВНЗАГФОЕВШТТЦРПХГРКУ -ЧЖОРЯПЧЬКЙХРЫС

|

5,0

|

0,0

|

| При учете реальных вероятностей :

|

| отдельных букв 3-х - буквенных сочетаний

|

2

|

ЕЫНТ ЦИЯЬА СЕРВ ОДНГ ЬУЕМЛОЙК ЭБЯ ЕНВТША ПОКАК ПОТ ДУРНОСКАКА НАКОНЕПНО SHE СТВО -

|

4,3

|

0,7

|

| 3

|

ЛОВИЛ СЕ ТВОЙ ОБНИЛ Ь

|

3,5

|

1.5

|

| 4-х - буквенных сочетаний

|

4

|

ВЕСЕЛ ВРАТЬСЯ НЕ СУХОМ И НЕПО И КОРКО

|

2,9

|

2,1

|

| 8-ми - буквенных сочетаний

|

1,8

|

3.2

|

| Выборка из реального текста

|

5

|

ПРИСВОИВ ДВОИЧНЫЕ НОМЕРА БУКВАМ АЛФАВИТА, МОЖНО ПВРЕВРАТИТЬ ЛЮБОЙ ТЕКСТ В ЧЕРЕДОВАНИЕ ЕДИНИЦ И НУЛЕЙ

|

1,0

|

4,0

|

| При РА

= 1;

РБ

-Рв

-.-.-Ря

= О

|

АААА. .

|

0,0

|

5,0

|

В результате взаимной корреляции букв в употребляемых в текстах буквенных сочетаний происходит дополнительное уменьшение определяемой выражением (1.13) реальной энтропии Нr

по сравнению с определяемой выражением (2.4) максимальной энтропии Нmax

. Подстановка значения Нr

, вычисленного с учетом взаимной корреляции букв, в выражение (2.6) дает дополнительное увеличение численного значения избыточной информации In

(таблица 1). Указанные свойства письменных текстов наглядно иллюстрируются таблицей искусственных текстов, полученных путем случайных выборок из реальных текстов отдельных букв или их сочетаний. Вместе с тем, указанная таблица показывает, что вместе с увеличением избыточности увеличивается и упорядо ченность (детерминация) текста, достигая в пределе «жесткой детерминации», при которой текст вырождается в повторение одинаковых букв.

Такая взаимосвязь между избыточностью и упорядоченностью текста обусловлена тем, что избыточность текста обусловлена действием грамматических и фонетических правил. Именно этими правилами обусловлена присущая тексту структурность, следовательно, вычисляемое согласно (2.6) количество избыточной информации In является одновременно и количеством информации, сохраняемой в упорядоченой структуре текста или любых других структурированных систем :

Для уяснения смысла равенства In

=

D

IS

, вытекающего из сопоставления выражений (2.6) и (2.7), рассмотрим следующий пример.

Некто получил сообщение, что из яйца вылупился птенец. Для подтверждения того, что это именно птенец, а не малек, сообщается, что у него не плавники, а крылья, не жабры, а легкие и т.п. Разумеется, все это не будет избыточной информацией In

для всякого, кто знает, чем отличается птенец от малька.

Но та же самая информация о крыльях, легких, клюве и т.п., заложенная в генетический код, регулирует процесс онтогенеза, в результате которого в яйце формируется организм птенца, а не малька. Таким образом, информация In

, избыточная для осведомленного получателя, оказывается необходимой структурной информацией D

IS

, когда речь идет об информационном управлении процессами формирования тех или иных упорядоченных структур. Вследствие этого и выполняется условие :

| In

= D IS

= Hmax

– Hr

|

(2.8)

|

ИНФОРМАЦИОННО-ЭНТРОПИЙНЫЕ СООТНОШЕНИЯ ПРОЦЕССОВ АДАПТАЦИИ И РАЗВИТИЯ

Одна из теорем Шеннона свидетельствует об уменьшении информационной энтропии множества АВ,

образованного в результате взаимодействий двух исходных упорядоченных множеств Либ.

| H (A,B) ≤ H(A) + H(B)

|

(3.1)

|

В этом соотношении знак равенства относится к случаю отсутствия взаимодействий между множествами А

и В .

В случае взаимодействий происходит уменьшение энтропии на величину:

D H = Н(А) + Н(В) - Н(А,В) (3.2)

Согласно негэнтропийному принципу информации (3.4)

получаем :

D IS

=Н(А) +Н(В) - Н(А,В) (3.3)

Распространяя рассмотренные Шенноном взаимодействия абстрактных математических множеств на случаи взаимодействий реальных физических систем, можно сделать следующие выводы :

1. Соотношения ( 3.1 ), (3.2) и (3.3 ) можно распространить на случаи взаимодействий упорядоченных физических систем, в частности на взаимодействия физических сред с различными видами полей.

При этом необходимо осуществлять переход от информационной энтропии Н

к термодинамическай энтропии S

, используя соотношение (1.4)

Приложений 1.

2. Знак равенства в соотношении (3.1) соответствует случаю отсутствия взаимодействия между рассматриваемыми физическими системами (например, случай воздействия магнитного поля на не обладающую магнитными свойствами среду).

3. Во всех остальных случаях в соответствии с соотношением (3.3) происходит накопление структурной информации D IS

, характеризующей увеличение упорядоченности структуры вновь образующейся системы (формирование и ориентация магнитных доменов под воздействием магнитного поля, структуализация под воздействием электрического поля поляризуемых сред и т.п.).

С помощью вероятностной функции энтропии можно описать формальным математическим языком процесс адапации системы к внешним воздействиям, понимая процесс адаптации как обучение оптимальному поведению в заданных условиях внешней среды.

Рассмотрим систему, обладающую возможностью выбора одного из N

возможных ответов (реакций) на внешние воздействия. До прохождения обучения система способна отвечать на любые воздействия лишь выбранной наугад реакцией i

, причем i

может принимать любые значения от i

= 1

до i

= N

, т.е.:

i=1,2,3,.. . N , (3.4)

При этом условии вероятности всех ответов равны друг другу, т.е.:

Р1

= Р2

= … =PН

=1/N (3.5)

Как было показано ранее,

при этом условии реальная энтропия Н

r

равна максимальной энтропии Hmax

, т.е.:

| Hr

= -

|

i = N

|

pi

log pi

= log N = Hmax

|

(3.6)

|

| S

|

| i = 1

|

В результате обучения возникают различия вероятностей разных реакций.

В соответствии с рассмотренными ранее свойствами функции

реальная энтропия Hr

уменьшается на величину

С точки зрения теории вероятностей начальный алфавит с заданным числом букв представляет собой полную группу событий.

Для полной группы событий при любом распределении вероятностей сумма их всегда равна 1 , согласно известному из теории вероятности условию нормировки:

| i = N

|

pi

= 1

|

(3.6)

|

| S

|

| i = 1

|

Смысл условия нормировки заключается в том, что сумма вероятностей выпадения всех 6-ти граней игральной кости равна вероятности выпадения любой грани, т.е. :

Р1

+ Р2

+ … Р6

= 1

/6

+ 1

/6

+ … + 1

/6

= 1

6

раз

В рассматриваемом нами процессе обучения, приводящем к дифференцировке значений вероятностей реакций Pi

,

составляющих полную группу N,

условие (3.8)

свидетельствует о том, что увеличение вероятностей каких -то реакций может происходить только за счет уменьшения всех остальных вероятностей (чтобы сумма была по-прежнему равна 1,

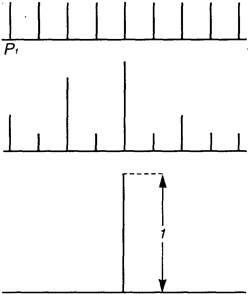

см. рис. 1, случай

б

).

В предельном случае одна из N

вероятностей может возрасти до 1

, тогда все остальные вероятности станут равны 0

(рис. 1).

В случае текста предельному случаю дифференцировки соответствует вероятность одной буквы (например, «е»), равная 1

. Вероятности всех остальных букв при этом равна нулю. Это значит, что текст вырождается в повторение одной буквы

е е е е е ...

Этот случай соответствует жесткой детерминации (незатухающий строго периодический процесс).

Соответствующее жесткой детерминации распределение вероятностей, при котором некая вероятность Рк

равна 1

, а все остальные - равны 0,

в общем виде запишется как

Рк=1 (3.9)

Р1

= Р2

= . . .= Рк-1

= Рк+1

=. . .= 0 (3.10)

| Равномерное распределение вероятностей

Нr

= Hmax

Дифференцировка вероятностей при соблюдении условия

i=N

S

pi

= 1

i=1

Hmax

> Hr

> 0

Предельный случай дифференцировки вероятностей

Н

r

=

0

|

При подстановке этих значений в функцию энтропии :

| Hr

=

|

i = N

|

pi

log pi

|

(3.11)

|

| S

|

| i = 1

|

получаем :

Hr

=0

(3.12)

Подставляя (3.9)

в (3.4),

получаем :

D IS

= Hmax

(3.13)

Все стадии перехода от состояния максимальной энтропии, описываемого условиями (3.4), (3.5), (3.6),

к состоянию жесткой детерминации, которому соответствуют условия ( 3.9 ) + (3.13)

можно представить в виде дуги, соединяющей исходное состояние Н

с конечным состоянием К (рис. 2).

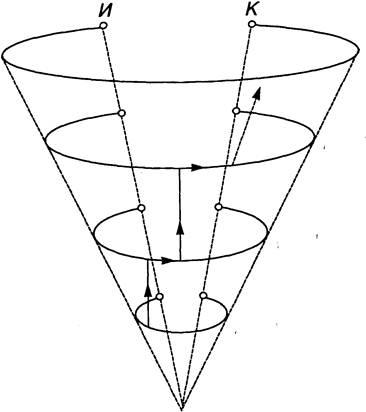

На рис.3

изображена расширяющаяяся иерархическая спираль, которая может служить моделью формирования иерархических упорядоченных структур.

Пусть нижний уровень этой спирали (

п = 0)

соответствует начальному алфавиту, состоящему из N0

различных элементов (букв, атомов, нуклеотидов и др.).

рис. 3

Тогда на уровне N

= 1

из этого алфавита можно составить N1

«слов». Если каждое слово состоит из K1

букв, то из N0

букв можно составить число слов, равное:

N1

= N0

K

1

(3.14)

Соответственно, на уровне п = 2

из N

1

«слов» можно составить количество «фраз», равное:

N2

=N

1

K

2

=N

0

K

1

K

2

(3.15)

где Кг -

число входящих в каждую «фразу» «слов»

Для упрощения математических выражений мы уже приняли одно допущение, сказав, что все слова содержат одинаковое количество букв (

К1),

а все фразы содержат одинаковое количество слов (

К2).

Очевидно, что в реальных системах (например, в письменных текстах ) эти условия не соблюдаются. Однако для выполнения общих свойств нашей информационно -энтропийной модели подобные упрощения вполне допустимы, поэтому мы введем еще одно допущение:

K

1

=

К

2

=

К

(3.16)

Подставив (3.16

)

в (3.15),

мы получим :

N2

=N0

K

2

(3.17)

Проводя аналогичные операции для любой (

п-ой)

ступени при условии:

K1

= K2

= … = Кп

= К,

получим:

Nn

= N0

K

2

(3.18)

Рассмотрим пример, иллюстрирующий увеличение разнообразия (числа различимых элементов) с переходом на более высокие уровни изображенной на рис . 3.3

спирали в соответствии с формулами (3.14) + (3.18).

Если алфавит (уровень п = 0)

содержит 30 букв (

N0

= 30),

а каждое «слово» искусственного текста состоит из 6 букв (К = 6),

то общее число таких «слов» составит:

N1

= N0

K

1

= 306

= 729 ·106

Среди указанного количества «слов» большинство составят бессмысленные или даже непроизносимые «слова» (из 6-ти гласных, 6-ти согласных и т.п.).

Но если хотя бы 0,01% от общего числа буквенных комбинаций составят осмысленные слова, общий лексикон составит 72 900 слов.

Еще более прогрессивно возрастает число комбинаций с переходами на более высокие уровни n

= 2,

п = 3

и т.д.

Для определения возрастания информационной емкости по мере перехода на более высокие уровни изображенной на информационно-энтропийной спирали напомним , что максимальное количество структурной информации A/s' накапливается при переходе от Н

r

′

=

Н

max

к Н

r

′′

= 0,

т.е. равно:

D IS

= Нr

′ – Нr

′′ = Hmax

Величина максимальной энтропии для п -

ой ступени определяется как:

Нпmax

= log Nn

= Кn

log N0

(3.19)

Сопоставляя величину Нпгнх с

величиной энтропии ступени n

=

О

H

0max

= log N0

(3.20)

убеждаемся, что в результате перехода с уровня n

= 0

на уровень n

,

максимальная энтропия возросла в К

n

раз :

Н

п

max

=К

n

Н

0max

(3.21)

При переходе от исходного состояния Н

в конечное состояние К

энтропия уменьшается от Н

r

=

Н

max

до Н

r

= 0,

а величина накапливаемой системой информации соответственно возрастает от I

=0

до D

IS

= Н

max

(см. рис 1).

При переходе с уровня n

=

О

на уровень n

в соответствии с увеличением энтропии в К

n

раз увеличивается значение D

I

Smax

то есть возрастает потенциальная емкость:

(

D

I

Smax

)0

= Kn

(

D

I

Smax

)0

(3.22)

В

качестве примера подсчитаем с помощью формулы (3.22),

как будут возрастать размеры витков спирали по мере увеличения номера ступени п .

Приняв условно диаметр витка при n

= 0

за 1

см.,

получим размеры вышележащих витков, сведенные в таблицу 2

.

Таблица

2

| п

|

1

|

2

|

3

|

4

|

5

|

6

|

| Диаметры витков в см.

|

1

|

6

|

36

|

216

|

1296

|

7776

|

Таблица 2

дает наглядное представление о степени прогрессивности роста информационной емкости по мере перехода на вышележащие витки. Нетрудно заметить, что при n

= 3 ,

размеры витка (36

см.)

близки к размерам раскрытой книжки, при n

=

5

–

к размерам довольно просторной залы (

с диаметром 12,96 м ) ,

а при п = 6

–

к размерам городской площади (

с диаметром 77,76 м ).

Вследствие роста информационной емкости система, поднимаясь в процессе развития на все более высокие уровни иерархической спирали и постоянно стремясь к состоянию жесткой детерминации, оказывается тем дальше от этого состояния (в смысле потенциальной возможности накопления информации), чем больше витков в этой спирали ей удается пройти.

Как уже отмечалось, системы в своем развитии, как правило, не достигают состояния жесткой детерминации. Условием их динамичного равновесия оказывается сочетание частично детерминированных , а частично вариабельных (вероятностых) внутренних связей. Соотношение степени детерминации и вариабельности внутренних связей может быть выражено количественно как отношение величины остаточной энтропии Н

r

к количеству накопленной и сохраняемой структурной информации D

IS

:

где G

–

коэффициент стохастичности (вариабельности, гибкости) внутренних связей.

Оптимальным соотношением жесткости и гибкости внутренних связей Gopt

оказывается такое соотношение, которое соответствует степени вариабельности условий внешней среды.

Результаты исследований статистических свойств письменных текстов дали близкие результаты для всех европейских языков:

G @ ¼

Очевидно, эта величина G

является для языка оптимальной, так как она характеризует соотношение, возникшее в результате эволюционного развития языка. Будучи величиной статистической, она может варьироваться в зависимости от характера текста: для служебных бумаг и инструкций G < G

opt

,

для поэтических текстов G > Gopt

.

Чем больше величина G,

тем менее избыточным будет текст. Избыточность текста характеризуется коэффициентом избыточности R

,

определяемым как:

| R =

|

Hmax

- Hr

|

=

|

D IS

|

(3.24)

|

| Hmax

|

Hmax

|

Сопоставляя (3.23)

и (3.24).

можно выразить величину G

через R

как:

ИНФОРМАЦИЯ И ЭНЕРГИЯ

Для выявления взаимосвязи структурной информации с внутренней энергией систем воспользуемся уравнением Гельмгольца:

U=F+ST

(4.1)

где: U

-

внутренняя энергия ;

F

- свободная часть внутренней энергии ;

ST

-

связанная (энтропийная ) часть внутренней энергии ;

S

- физическая энтропия ;

Т

- абсолютная температура.

В состоянии термодинамического равновесия вся внутренняя энергия становится «энтропийной», а сама энтропия достигает максимальной величины[3]

.

Таким образом , при достижении равновесия достигается условие:

F=0

(4.2)

из которого, согласно (4.1)

следует:

U = Smax

T

(4.3)

или:

Преобразуем выражение (4.1),

поделив левую и правую части уравнения на Т:

Подставляя (4.4)

в (4.5)

и перенося член S

в левую часть с противоположным знаком, получаем :

Для дальнейшего рассмотрения к входящему в выражение члену S

добавим индекс r

,

имея в виду, что Sr

–

это та реальная энтропия, внутренняя энергия которой определяется выражением (4.1).

Учитывая, что в соответствии с соотношением (

1

.

4

)

S = K H

(4.7)

приведем выражение (4.6)

к виду:

| F

|

=

|

K ( Hmax

– Hr

)

|

(4.8)

|

| T

|

где К

–

постоянная Больцмана;

Нтах

–

максимальная информационная энтропия ;

Н

r

–

реальная информационная энтропия .

Сопоставляя (4.8)

с ранее полученным выражением (2.7)

получаем :

Полученное соотношение свидетельствует о том, что при неизменном значении температуры Т

свободная часть внутренней энергии F

зависит только от количества сохраняемой системой структурной информации D

IS

.

Другими словами, свободная энтропия F

–

это часть энергии, которая расходуется на определяющие структурную организацию системы межэлементной связи.

Г.Гельмгольц назвал эту часть внутренней энергии «свободной энергией» имея в виду, что эту энергию, в отличие от составляющей внутренней энергии ST

,

можно «освободить» для той или иной полезной работы. Такое «освобождение» осуществляется путем разрушения внутренних связей, определяющих структуру используемых для этой цели систем: сжигания органических веществ (нефти, угля), разрушения атомов или атомных ядер и т.п.

Введем понятие потенциального коэффициента полезного действия η, показывающего, какая часть внутренней энергии может быть, в принципе, использована для полезной работы:

С учетом (4.4)

и (4.9)

выражение (4.10)

приводится к виду :

Сопоставляя (4.11)

с выражением (3.24),

приходим к выводу, что потенциальный КПД η равен коэффициенту избыточности R.

Рассмотрим два крайних состояния систем, одному из которых соответствуют условия D

IS

=

0

(состояние равновесия), а другому – D

IS

= Н

max

(жесткая детерминация) .

В соответствии с выражением (4.11)

в состоянии равновесия η

= 0

(поскольку вся внутренняя энергия в этом случае оказывается не «свободной», а «связанной», т.к. F

= 0,

a U

=

Smax

T

).

При жесткой детерминации (

D

IS

= Н

max

)

в

соответствии с (4.11)

,

η

= 1.

Это условие означает, что вся внутренняя энергия расходуется только на сохранение межэлементных структурных связей, поэтому структура такой системы останется неизменной (жестко детерминированной ) до тех пор, пока система не разрушится под влиянием изменившихся условий внешней среды.

При неизменных внешних условиях и при η

= 1

осуществляется «вечное движение», примером которого может служить жестко детерминированное движение небесных светил и планет.

ЗАКЛЮЧЕНИЕ.

Подводя итог всему, что было сказано выше, отметим, что по мере того, как рациональная наука все глубже и глубже постигает сложность организации существующих в мире систем она все в большей мере осознает недостаточность ранее признанных редукционистских концепций. Поиски источников информации определяющей структуры и функции сложных систем, приводят науку к необходимости создания телеологических концепций, то есть, в конечном счете, к признанию некого организующего начала, которое и есть не что иное, как проявление воли Творца.

СПИСОК ЛИТЕРАТУРЫ

1.

Седов Е., Кузнецов Д. В начале было Слово…

–

СПб., 1994.

2.

Шеннон К.Е. Математическая теория связи. Работы по теории инфор -мации и кибернетике., М, 1963.

3.

Шеннон К. Е. Бандвагон. /Работы по теории информации и кибернетике/, М., 1963.

4.

Бриллюэн Л. Научная неопределенность и информация, М.,1966.

5.

Винер Н. Кибернетика, или Управление и связь в животном и машине.

М,1968.

6.

Аптер М. Кибернетика и развитие М. 1970.

7.

Седов Е.А. Взаимосвязь информации, энергии и физической энтропии в процессах управления и самоорганизации. Информация и управление. М., Наука, 1986.

8.

Седов Е.А. Эволюция и информация. М., Наука, 1976.

9.

Шеннон К. Е. Предсказание и энтропия английского печатного текста.

10. Пригожий И., Ствнгврс И. Порядок из хаоса. М.. Прогресс, 1986.

11. Тейяр де Шарден Феномен человека. М., Наука, 1987.

[1]

Зависимость вероятностей последующих событий от предыдущих определяется в теории вероятностей термином «корреляция».

[2]

Близкое к указанному сочетание избыточной и непредсказуемой информации было затем получено в результате анализа тестов на русском и ряде европейских языков.

[3]

Данное состояние относится к категории теоретических абстракция, поскольку при достижении термодинамического равновесия не разрешается структура элементарных частиц.

|